Inteligência Artificial e Modelação

BLOG

Na presente primavera da Inteligência Artificial (IA), uma área de conhecimento foi esquecida. Uma área relevante e sem a qual a IA não pode progredir em domínios como as ciências sociais, o urbanismo, a saúde (para além do prognóstico) ou o desenvolvimento de software. Falamos da representação de conhecimento complexo. Da Modelação.

O ATUAL BOOM DA INTELIGÊNCIA ARTIFICIAL

O ano de 2019 é representativo do entusiasmo vivido em Portugal em torno da inteligência artificial. A excelente exposição sobre o cérebro na Fundação Gulbenkian, entre maio e junho, recebeu a visita de dezenas de milhares de pessoas. A inteligência artificial foi o tema do ciclo de conferências Fidelidade-Culturgest, com apoio científico do IST, durante o segundo trimestre do ano. A Vodafone organizou a sua Business Conference, na Alfândega do Porto, a 8 de maio, sobre a nova era da inteligência artificial. Em conjunto com o IST, a Quidgest organizou já duas Talks on MDE&AI. As tecnológicas portuguesas Unbabel, Talkdesk, Opentalk, DefinedCrowd e Feedzai são elogiadas pela comunicação social devido à utilização inovadora de inteligência artificial. Investigadores de há muitos anos saíram do relativo anonimato e são hoje reconhecidos pelo grande público: Pedro Domingos, Ana Paiva, Manuela Veloso, Luísa Coheur, Mário Figueiredo, Arlindo Oliveira, Luís Moniz Pereira, Virgínia Dignum. Atualmente, a IA mobiliza investigadores, estudantes, investidores, decisores e empresários, mas também um número crescente de interessados que pretendem, tão-só, estar bem informados sobre o tema.

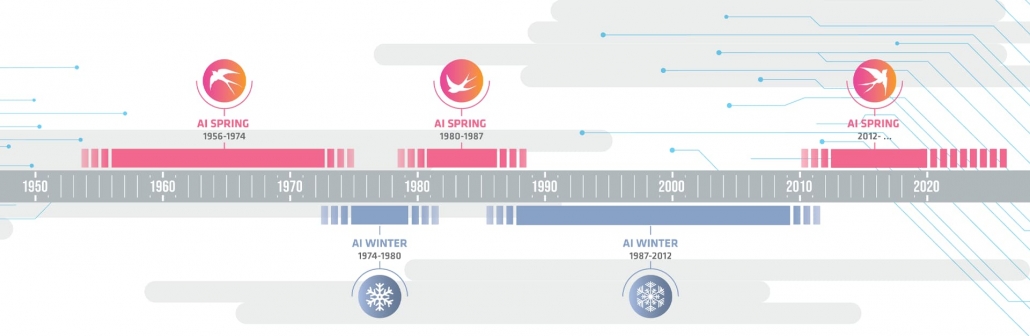

OS ALTOS E BAIXOS DA INTELIGÊNCIA ARTIFICIAL AOS LONGO DA SUA HISTÓRIA

O entusiasmo com a inteligência artificial não é novo. Porém, a cada um dos booms (“primaveras”), seguiu-se um desanimador inverno.

Na atual primavera da IA, quer a perspetiva de mais um insucesso e desilusão de um novo inverno, quer um extraordinário sucesso (no limite, implicando o domínio das máquinas sobre a inteligência humana) geram receios e preocupações. Na Quidgest queremos afastar-nos da discussão em torno deste último cenário.

Ele pressupõe a passagem da Narrow AI (IA para resolver problemas específicos) para a Generic AI (IA para resolver quaisquer problemas que um humano consiga resolver) e, finalmente, para a Super AI (IA que se reproduz a si própria, sem intervenção humana). Receamos que discutir esta presumível ameaça conduza apenas a distopias pouco fundamentadas, contribuindo apenas para reações primárias e não suportadas por inteligência.

Na prática, a IA específica (Narrow AI) é aquela com que todos trabalhamos hoje em dia. É a que nos propomos ajudar a melhorar, em particular no que pode apoiar a transformação digital de estruturas produtivas e da sociedade. Revemo-nos, inclusive, nos objetivos de desenvolvimento sustentável 2030 e das conferências “AI for Good” das Nações Unidas.

O QUE ACONTECEU NOS ÚLTIMOS 25 ANOS?

A inteligência artificial hibernou e esteve adormecida até há cerca de cinco anos. Mas, subitamente, começou a aparecer associada a domínios tão diversos como condução autónoma, recomendações e sugestões em redes sociais, plataformas de comércio eletrónico, diagnóstico médico, reconhecimento facial, otimização de percursos, deteção de fraudes, assistência virtual, geração de narrativas ou compreensão de linguagem natural.

Mais do que novos conceitos, os avanços na velocidade e na capacidade de computação fazem a grande diferença entre a IA da primeira década deste milénio e a IA da década de 80 do séc. XX (a data da última primavera). Ao mesmo tempo, numa operação bem sucedida, a IA abarcou a data science e, com esta, a estatística e os métodos quantitativos).

Ao mesmo tempo que beneficia de todos os avanços tecnológicos destas décadas, a nova geração de investigadores da inteligência artificial pode ter, em relação à geração anterior, esquecido alguns desafios, algumas preocupações e alguns domínios de conhecimento relevantes. Como já antes referido, interessa-nos analisar, em particular, o que aconteceu à representação do conhecimento complexo.

O conhecimento é representado por modelos. O modelo é uma conceção simplificada, independente e útil da realidade. Através de regras, com pressupostos e semântica próprios, traduz o que se sabe sobre essa realidade. Pode ser continuamente alargado ou refinado, nomeadamente pela incorporação de novos padrões. Pode representar de forma diferenciada determinados aspetos da realidade, para os estudar mais facilmente. Pode ser avaliado. Pode ser testado. Permite efetuar simulações, antecipar comportamentos ou prever evoluções.

Pedro Domingos apresenta o seu bestseller “O Algoritmo Mestre” como “um modelo concetual da aprendizagem automática” e refere que a expressão “modelo concetual” foi criada pelo psicólogo Don Norman para indicar “o conhecimento básico de uma tecnologia que nos é necessário para que possamos usá-la com eficácia”. Porém, numa geração de IA focada na aprendizagem e no algoritmo, os modelos estão ausentes ou sub-representados.

O QUE ACONTECEU À REPRESENTAÇÃO DO CONHECIMENTO COMPLEXO?

Noutros períodos de investigação e de investimento em IA, esta área era designada por expert systems ou sistemas periciais. Uma simples consulta ao Google Trends mostra que ainda há quinze anos (a memória da internet não é mais longa), expert systems e machine learning (ML) ocupavam posições semelhantes nas pesquisas. Mostra também que ambos estiveram numa tendência descendente até 2011 e que, até 2014, o interesse por estes termos se manteve abaixo do que existia dez anos antes, mas já com uma evolução claramente diferente dos dois conceitos, com o ML a recuperar e os sistemas periciais a tornarem-se irrelevantes na procura.

Atualmente, o machine learning bate os sistemas periciais por 100 contra 1, com o interesse sobre ML a crescer em exponencial, sendo garantido que a tendência de futuro é para esta separação se acentuar ainda mais.

O MODELO E NÃO APENAS O ALGORITMO

Não vamos ressuscitar os sistemas periciais que parecem condenados a ter apenas um lugar na história. Mas queremos destacar a necessidade de acompanhar o progresso da inteligência artificial com a representação do conhecimento complexo, através de modelos. O modelo e não apenas o algoritmo.

Na evolução do conhecimento, o modelo é a formulação do problema, a tese, as regras do jogo, a questão que é colocada. O algoritmo é a forma de solucionar aquele problema ou de ganhar aquele jogo. Modelo e algoritmo são dois conceitos interligados e não opostos. Inteligência é tanto a criação do modelo (a invenção do xadrez) como a descoberta do algoritmo (como ser campeão de xadrez).

Porém, é evidente que a presente vaga da inteligência artificial está muito mais focada em no algoritmo do que no modelo. A Quidgest não pode estar de acordo com esta visão parcial.

AS LIMITAÇÃO DA ATUAL INTELIGÊNCIA ARTIFICIAL FACE À ÚLTIMA GERAÇÃO

Existem três limitações graves da presente vaga de IA face ao que já tinha sido alcançado pela anterior, há três décadas:

- A não evolução na modelação do conhecimento complexo;

- O esquecimento da inferência lógica e do conhecimento baseado em regras;

- O foco em problemas com respostas simples (dicotómicas, rankings, ações limitadas a um número de opções reduzido).

A AUSÊNCIA DO CONHECIMENTO EXPLÍCITO

A atual IA considera a explicitação do conhecimento desnecessária. A máquina descobre algo e ficamos maravilhados com o facto de a máquina ter feito uma descoberta, que julgávamos apenas ao alcance dos humanos ou que mesmo os humanos não conseguem descobrir.

Na realidade, existe um modelo, mesmo quando não existe modelo. É o modelo da ausência do modelo e é uma opção perigosa. O modelo não é declarado, não é pensado, não é avaliado e baseia-se em estereótipos.

Porque se removem outliers na inferência estatística? Porque são todas as assistentes virtuais do sexo feminino?

A INFERÊNCIA OBRIGATORIAMENTE PROBABILÍSTICA

A atual IA, pela relevância dada ao machine learning, é probabilística. Mas a inteligência natural só é probabilística quando o tem de ser. A inferência lógica, que conhecemos e com que trabalhamos desde os silogismos dos filósofos da Grécia antiga, é tanto ou mais válida quanto a inferência estatística. E, contudo, a atual IA esqueceu e não usa a programação lógica, com Prolog, a representação do conhecimento baseada em regras declarativas, ou os motores de inferência, como o Velocity, usado pela Quidgest para a geração automática de sistemas de informação complexos. Adicionalmente, a não explicitação das regras de inferência usadas resulta num problema grave, que analisaremos mais tarde: o da opacidade e da não transparência das decisões.

A APLICAÇÃO A OPÇÕES EM NÚMERO REDUZIDO

A atual IA lida com problemas que podem ser muito complexos mas está focada em resultados simples, dentro de um leque de opções limitado. O que a atual IA nos dá são respostas dicotómicas, rankings ou movimentos limitados.

A condução autónoma não é exceção. Conduzir um automóvel é avançar ou recuar, aumentar ou reduzir a velocidade, virar para a direita ou para a esquerda. Um número reduzido de opções. Mas sendo objetivo chegar a um determinado local a determinadas horas, com um estilo de condução definido e tendo em conta a situação do trânsito, terá de haver um modelo por trás e não apenas aprendizagem.

Manter uma conversa ou escrever um relatório também parece exigir mais do que uma resposta simples. Mas as conversas com as assistentes virtuais atuais são sequências sem um fio condutor. Os assistentes virtuais podem vir a atingir, no futuro, o objetivo de construir uma conversa fluente, mas vão precisar de um modelo para o fazer. Na realidade, é muito possível que esse modelo já esteja lá, apesar de a IA se envergonhar de o reconhecer e atribuir tudo à inteligência do assistente virtual. Compra bilhetes para o cinema, reserva um restaurante perto do cinema, assegura o transporte. Não é um conhecimento muito elaborado, mas há um modelo, uma sequência lógica, a suportá-lo.

Seja pela dificuldade inerente, seja por purismo, tudo o que exige mais do que uma decisão simples ou uma sequência de decisões simples não está a ser considerado IA. Por exemplo, nas várias conferências a que assistimos, a programação de software não faz parte das aplicações da inteligência artificial atual. A Quidgest pretende provocar uma alteração nesta situação.

O MURO DA IA

Não é só na fronteira mexicana. Os muros não são úteis para a IA, nem para a inovação em geral. Esta vaga de IA faz muito bullying: “isso é IA”, “isso não é IA”. A questão não vem de agora e há uma citação conhecida que diz que logo que algo é divulgado e se torna comum, deixa de ser classificado como IA.

A IA atual é também seletiva ao aplicar muitas vezes o epíteto de “pouco inteligente”: um programa de xadrez, mesmo que bata o campeão do mundo, é “pouco inteligente” porque é específico. No entanto, é reconhecido que toda a IA investigada hoje em dia é específica (é Narrow AI) e não genérica. Por isso para quê a diferença?

O processo de negação e não de síntese, de geração para geração, está a tornar-se a norma na história da inteligência artificial. Do mesmo modo que a segunda primavera (o boom dos expert sytems) se referia à primeira depreciativamente por GOFAI (Good Old-Fashioned Artificial Intelligence), também a atual vaga (do machine learning) olimpicamente ignora tudo o que possa ter sido aproveitado do boom anterior.

Colocar um computador a escrever sistemas de informação muito complexos, tal como a Quidgest faz, mesmo que com uma qualidade e (naturalmente) uma velocidade muito superior à de uma equipa de vários programadores, tem que lutar para ser considerado IA. Afinal, não está entre as disciplinas oficiais da IA atual. Não é ML, não é classificação de dados, não é processamento de linguagem natural. Será, quanto muito, robótica.

OS PROCESSOS NEURONAIS SÃO MAIS ANTIGOS DO QUE OS CÉREBROS

Também não se defende o contrário: ignorar o valor das redes neuronais e do machine learning, por absurda retaliação da “velha escola”.

A ciência está a descobrir que há outros cérebros. Há seres vivos desprovidos de cérebro que seguem estratégias inteligentes. Há um reconhecimento da inteligência coletiva de um formigueiro ou de um enxame, ou mesmo de uma cidade ou de uma língua viva. Se o cérebro humano não é o único modelo de inteligência, os processos que a evolução veio a transformar em processos neuronais são mais antigos do que podemos imaginar.

No seu livro “A Estranha Ordem das Coisas”, António Damásio fala do enorme êxito das bactérias. “Peço, por um momento, ao leitor que esqueça a mente e o cérebro humano e pense, em vez disso, na vida das bactérias. […] As bactérias são criaturas muito inteligentes, não há outra maneira de o dizer, mesmo que essa inteligência não seja orientada por uma mente com sentimentos e intenções e um ponto de vista consciente. Elas sentem as condições do ambiente e reagem de formas vantajosas para a continuação das suas vidas. Entre essas reações contam- se comportamentos sociais complexos. Comunicam entre elas – sem palavras, é verdade, mas as moléculas com que trocam mensagens valem por mil palavras. Os cálculos que realizam permitem-lhes avaliar a situação em que se encontram e viver de forma independente ou unir-se, consoante o que melhor for. Estes organismos unicelulares não possuem sistema nervoso nem mente, no mesmo sentido em que os temos. Não obstante, dispõem de variedades de perceção, memória, comunicação e orientação social mais do que adequadas às suas necessidades. As operações funcionais que sustentam toda esta «inteligência sem cérebro nem mente» dependem de redes químicas e elétricas do tipo que os sistemas nervosos vieram a dispor, a desenvolver e a explorar mais tarde na evolução.”

OPACIDADE DO SOFTWARE E DA IA

No FINLAB, uma iniciativa promovida pelos três reguladores do sector bancário nacional – Banco de Portugal, CMVM e ASF –, a Quidgest foi convidada a demonstrar o que tem feito com inteligência artificial no domínio da regulação financeira. O exemplo que apresentámos foi a utilização de uma rede neuronal para reduzir o custo administrativo de falsos positivos na deteção de eventuais operações de branqueamento de capitais. Na ocasião, foi exigência unânime que o raciocínio por trás da decisão seja explicado. Ou as redes neuronais evoluem no sentido de se saber explicar ou não são aceites pelos reguladores. O que faz sentido. Toda a IA (incluindo ML)

Quem conhece os sistemas de gestão de recursos humanos da Quidgest sabe que, desde a sua conceção, uma das funções essenciais, o processamento de vencimentos, é acompanhada de uma explicação detalhada dos cálculos efetuados. Este é um diferenciador da solução e é uma forma de transparência. Do mesmo modo, os sistemas de contabilidade da Quidgest não apenas efetuam toda a movimentação contabilística de forma automática, como a apresentam aos utilizadores. No cálculo de comparticipações em despesas de saúde (uma tarefa complexa onde entram variáveis como a idade, o plano subscrito, o tipo de serviço, a validade dos documentos, limites, incompatibilidades e outras exigências específicas), por cada regra e variável relevante considerada, é acrescentada a explicação do cálculo. Os sistemas que desenvolvemos são, by design, transparentes.

A autocracia do software não é desejável, mas na atual IA parece não incomodar. O problema, como refere Stuart Russel, é o alinhamento do valor (value alignment problem), é alinhar o algoritmo com a função objetivo. Sem um modelo de conhecimento é muito difícil definir exatamente quais os objetivos.

Russel recorda-nos a história do Rei Midas: uma formulação clara e otimizada (“tudo em que tocar quero que se transforme em ouro”) que o levou à morte pela fome. Quando os nossos objetivos são determinados por uma representação limitada da realidade, não analisada em todas as perspetivas e em todas as suas consequências, isto é o que vai acontecer. Algoritmos que descobrem mecanismos de execução das nossas funções que não imaginamos (e sobre as quais nãopedimos que nos prestem contas) são novas mãos de Midas.

FORMAÇÃO PARA A INTELIGÊNCIA ARTIFICIAL

A ideia de que IA são algoritmos de aprendizagem (ML) que não requerem modelos de conhecimento é tanto mais perigosa quanto é a que está a ser passada às novas gerações de investigadores. Privilegiar apenas a inteligência e não o conhecimento é naturalmente atrativo para os novos investigadores. Como dizia George Orwell: “Every generation imagines itself to be more intelligent than the one that went before it, and wiser than the one that comes after it”. Cada geração imagina-se mais inteligente do que a anterior e mais sábia do que a seguinte.

A investigação fica mais simples, o estudo do estado da arte requer menos tempo, se ignorarmos todos os desafios que se colocavam há 30 ou há 60 anos. E, no entanto, como diz Jan Bosch: “We found several cases where people went out and started to employ all kinds of great deep learning solutions and it turns out that basic simple statistical approaches, going back a hundred plus years, actually were better than a deep learning algorithm”.

PERIGOS REAIS: O CASO DO MCAS DO BOEING 737-MAX

Se esta primavera da IA murchar será por se ter dado muito poder ao algoritmo (à máquina) e pouco à modelação (ao conhecimento). Existe hoje em dia um excesso de confiança na IA algorítmica. Um excesso de confiança que, em poucos meses, já matou 189 pessoas num voo da Lion Air e outras 157 num voo da Ethiopian Airlines.

Ausência de variáveis no modelo (nomeadamente distância do solo), reduzida interação com a envolvente (nomeadamente, com os pilotos), falta de necessidade de justificar as suas decisões e ações. Tudo o que de mau se pode esperar da IA no futuro esteve já presente nestes acidentes (e será que podemos considerar acidente um algoritmo que foi perfeitamente executado?). E, contudo, os impactos (na aprendizagem, na penalização financeira em bolsa da Boeing) foram limitados e circunscritos à aviação. A IA como um todo não parece ter aprendido nada com estes acidentes fatais. Talvez até se possa dizer que a excitação em torno da automação e da inteligência artificial de certo modo branqueou estes efeitos.

De todas as conferências sobre inteligência artificial a que assistimos desde março de 2019, e que têm contribuído muito para o hype em torno do tema, quantos oradores reviram a sua argumentação tendo em consideração os dois desastres com o caso do MCAS do Boeing 737 Max? Sem modelos adequados por trás, a inteligência artificial tem todas as condições para resultar em “artifical stupidity”.

IA NO DESENVOLVIMENTO DE SOFTWARE DE GESTÃO COMPLEXO

Mesmo estando na moda, em Portugal e no mundo, a inteligência artificial não tem estado a ser aplicada ao principal problema tecnológico da nossa época: a transformação digital requer uma capacidade de desenvolvimento de software (incluindo componentes de IA) que atualmente não existe. O problema tem levado à reconversão de muitos profissionais para a programação, promovido a importação de cérebros pelos países que o podem fazer, desenvolvido academias de código ou levado a propostas para formar as crianças em programação a partir do infantário.

Mas a automação do desenvolvimento de software, suportada por IA, não faz parte dos planos. Nem ao nível académico esta automação é suficientemente estudada. Espera-se que a academia mostre a aplicabilidade de uma técnica, antes de a indústria abordar todos os problemas adicionais da engenharia de produção com essa técnica. Mas são raros os casos, no universo académico, em que o desenvolvimento de software através de qualquer forma de automação inteligente seja um tema curricular ou sobre o qual exista investigação, dissertações ou artigos. A passagem da IA académica para a utilização industrial de IA é um desafio adicional. Enquanto que a investigação académica se faz a uma escala reduzida, afetando poucas pessoas, através de pilotos.

A MODELAÇÃO DE SISTEMAS DE INFORMAÇÃO MUITO COMPLEXOS

O domínio de investigação da Quidgest, que perdura desde a última primavera da inteligência artificial, há já três décadas, é a representação de software de gestão complexo através de modelos e a sua geração automática. É uma investigação já ao nível

industrial, com todos os requisitos de escalabilidade, eficiência, fiabilidade e robustez que tal acarreta. E traduz-se no Genio.

Os sistemas desenvolvidos pela Quidgest e pelos seus parceiros, através do Genio, são:

- definidos sem ambiguidades e de forma declarativa através de um modelo, incluindo vários tipos de componentes (persistência, interação, fluxos de trabalho, regras de negócio, segurança, etc.) para as quais foram identificados padrões;

- gerados automaticamente, uma vez validado o modelo e usando inferência determinística.

O Genio da Quidgest acumulou conhecimento ao longo dos últimos trinta anos e comporta-se como um perito em todos os domínios requeridos pela complexa tarefa de desenvolvimento de software de gestão empresarial. Usabilidade, integridade, desempenho,

interação, globalização, adequação tecnológica e, até, capacidade de evolução não são segredos para o Genio. Neste processo, as soluções (incluindo ERP e sistemas verticais) criadas pelo Genio comparam-se com sucesso com os equivalentes produtos desenvolvidos pelas formas tradicionais. No desenvolvimento de software, a IA é muito mais competente do que a programação tradicional.